• کارنگی، اندیشکده معتبر آمریکایی در این تحلیل به تاصیرات و تبعات استفاده از هوش مصنوعی در جنگ ایران و اسرائیل پرداختهاست.

• این موسسه بینالمللی اشاره کرد؛ جنگ اطلاعاتی ایران و اسرائیل با استفاده گسترده از هوش مصنوعی، نمونهای نگرانکننده از چالشهای جدید در منازعات مدرن است. در این جنگ، هر دو طرف با تولید و انتشار محتوای جعلی ویدئویی تلاش کردند روایت خود را برجسته کنند؛ برای مثال، اسرائیل ویدئویی از حمله به زندان اوین منتشر کرد که با تحلیلهای فنی مشخص شد احتمالاً با هوش مصنوعی ساخته شده است، در حالی که واقعیت بمباران شامل تلفات غیرنظامیان و ویرانی گسترده بود.

• قطع اینترنت و کنترل شدید رسانهای توسط جمهوری اسلامی ایران باعث شد مردم ناچار به اعتماد به اخبار دولتی و روایتهای محدود و ناقص شوند. با بازگشت اینترنت، تبلیغات و ویدئوهای جعلی بیشتری از هر دو طرف منتشر شد که باعث سردرگمی و بیاعتمادی عمومی شد.

• این جنگ رسانهای با حجم بیسابقهای از محتوای هوش مصنوعی تولید شده همراه بود و تشخیص واقعیت را برای شهروندان و تحلیلگران بسیار دشوار کرد. ابزارهای فنی شناسایی محتوای جعلی هنوز کامل نیستند و گاهی نتایج متناقض ارائه میدهند، که باعث افزایش سردرگمی میشود.

• موسسه کارنگی تأکید میکند که فناوریهای شناسایی باید در دسترس و قابل استفاده برای مردم مناطق بحرانزده باشند و در طراحی آنها باید امنیت کاربران بهویژه در محیطهای سرکوبگر رعایت شود. همچنین، ضرورت وضع قوانین و مسئولیتپذیری شرکتهای فعال در حوزه هوش مصنوعی و رسانه برای جلوگیری از سوءاستفاده و انتشار اطلاعات نادرست بسیار مهم است.

• در نهایت، این جنگ فراتر از درگیریهای نظامی، نبردی برای کنترل روایت و واقعیت است که همچنان ادامه دارد و بر امنیت و آگاهی عمومی تأثیر عمیقی میگذارد.

کارنگی؛ این جنگ نشان داد که فاصله فزاینده میان پیشرفتهای پیچیده در فریبکاری با استفاده از هوش مصنوعی و توان کارشناسان برای شناسایی آن، به یک چالش جدی بدل شده و آغازگر مرحلهای ترسناک در منازعات جهانی است.

هوش مصنوعی: چهره تازه تبلیغات جنگی

۲۳ ژوئن ۲۰۲۵، سازمان WITNESS یک ویدئو از طریق واتساپ دریافت کرد که ابرهای دود را در حال برخاستن از زندان اوین در تجریش تهران نشان میداد. این فیلم از آپارتمانی نزدیک محل ضبط شده و پیامی کوتاه اما تکاندهنده همراه آن بود: «دارند سعی میکنند اوین را باز کنند.» این زندان بدنام – محل شکنجه، قتل و حبس مخالفان سیاسی، روزنامهنگاران و فعالان – بمباران شده بود. مقامات اسرائیلی این حمله را «نمادین» توصیف کردند؛ حرکتی علیه سرکوبگری جمهوری اسلامی. برای بسیاری از ایرانیان، شکستن دروازههای اوین نمادی پرطنین از امید به آزادی بهترین و شایستهترین فرزندان این سرزمین بود که سالها پشت این دیوارها محبوس مانده بودند.

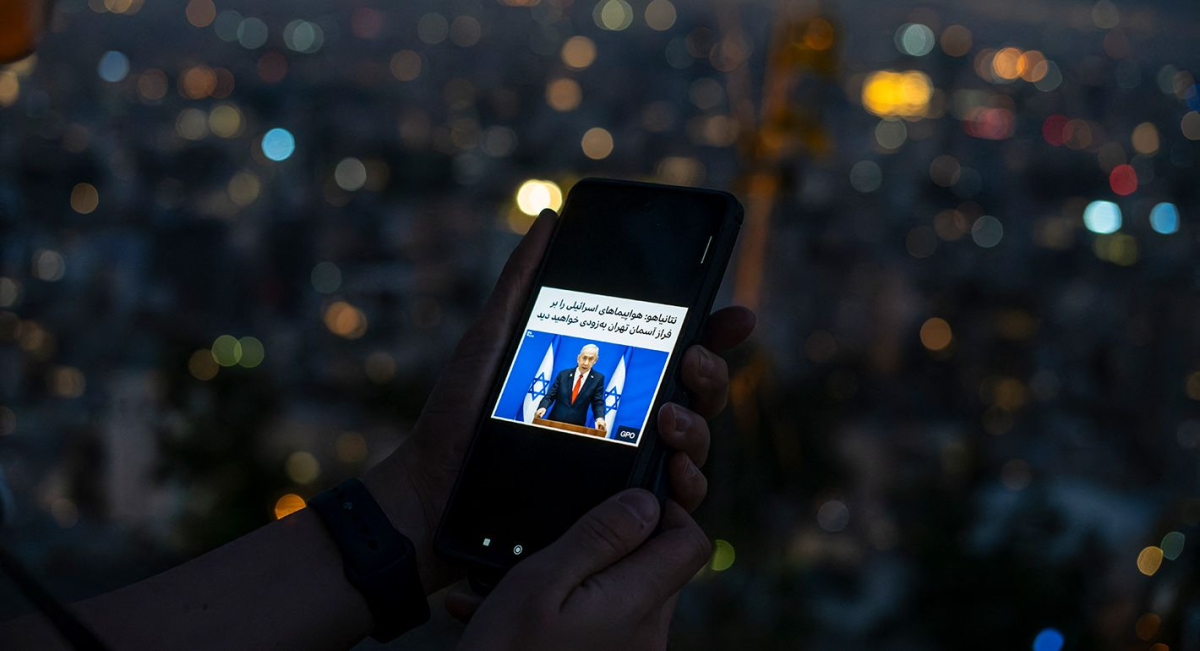

در شبکههای اجتماعی، اسرائیل تلاش کرد این رویداد را به نفع خود بهرهبرداری کند. وزیر خارجه این رژیم ویدئوی دیگری منتشر کرد که ظاهراً لحظه تخریب دروازه ورودی اوین را در یک حمله دقیق و حسابشده نشان میداد. او در شبکه ایکس (توییتر سابق) با لحنی شعاری نوشت: «زنده باد آزادی، لعنتی!» اما برخلاف ویدئوی اول، این نسخه اسرائیلی به احتمال زیاد جعلی بود.

بررسیهای فنی نشان داد که این ویدئو احتمالاً با استفاده از هوش مصنوعی ساخته شده است. برای نمونه، شامل تصاویری ثابت از دروازههای اوین بود که در مقالهای منتشرشده در سال ۲۰۲۱ دیده میشدند و میتوانستند با ابزارهای هوش مصنوعی دستکاری شده باشند. این یافتهها توسط «نیروی واکنش سریع دیپفیک» – سازوکار جهانی ارزیابی محتوای جعلی با هوش مصنوعی که توسط WITNESS اداره میشود – نیز تأیید شد.

در حالی که ویدئوی وزیر خارجه اسرائیل یک حمله دقیق و تمیز را نمایش میداد، واقعیت کاملاً متفاوت بود؛ بمباران اوین با تلفات جانبی گسترده همراه شد. گروههای حقوق بشری و شاهدان گزارش دادند که ساکنان و رهگذران اطراف زندان، خانوادههایی که برای ملاقات یا وثیقه آمده بودند، و حتی تعدادی از زندانیانی که اسرائیل مدعی «آزادسازی» آنها بود، کشته یا به شدت مجروح شدند. حتی برخی فعالان گفتند بازماندگان این حمله به مکانهایی با شرایطی بهمراتب وخیمتر منتقل شدند، چون ساختمان زندان تخریب شده بود.

هوش مصنوعی و تشدید بحران اطلاعاتی در ایران

فردی که ویدئوی واقعی اوین را برای ما ارسال کرد، در محله ستارخان تهران زندگی میکند؛ جایی که در موج نخست حملات هوایی اسرائیل در ۱۳ ژوئن – آغاز جنگ ایران و اسرائیل – هدف قرار گرفت. تجربه او نشان میدهد که چگونه مردم عادی ایران ناچار بودند در میان آتشباران، خاموشیهای گسترده و روایتهای متناقض از رویدادهای اطرافشان، راه خود را پیدا کنند.

با شدت گرفتن جنگ و درخواست اسرائیل برای تخلیه مناطق، برخی ایرانیان مهاجرت کردند، اما عدهای، مانند همان ساکن ستارخان، ماندند. تا ۱۸ ژوئن، بخش بزرگی از ایران از جمله تهران، درگیر قطع تقریباً کامل اینترنت شد که توسط خود جمهوری اسلامی اعمال گردید. این حکومت بارها به ویژه در جریان اعتراضات، اینترنت را قطع کرده تا جریان اطلاعرسانی و ارتباطات را کنترل کرده و از خیزشهای مردمی جلوگیری کند.

پس از آنکه در ۲۱ ژوئن بخشی از ارتباطات اینترنتی برقرار شد، مخاطب ما در ستارخان به پیامهای واتساپ پاسخ داد و نوشت: «همه چیز خوبه. راستش اسرائیل کاری به ما نداره. فقط دو شب پیش اومدن پایگاه بسیج محله رو بزنن، اشتباهی خونه بغلی رو زدن. خوشبختانه کسی تو خونه نبود. نگران نباشید، اگه این آخوندا ما رو نکشن، اسرائیل که قطعاً نمیکشه.»

اما این حرف واقعیت نداشت. او در ستارخان بسیار کمامنتر از آن بود که فکر میکرد. تنها چند روز پیش، «پرنیا عباسی» شاعر ۲۳ ساله همراه با خانوادهاش در همان محله با حمله هوایی اسرائیل کشته شده بود. در سراسر ایران، حملات اسرائیل شمار زیادی از غیرنظامیان ایرانی را کشته یا زخمی کرده بود. سازمان حقوق بشری «فعالان حقوق بشر در ایران» (HRANA) که مقر آن در آمریکا است، برآورد کرد که تا ۲۵ ژوئن، دستکم ۴۱۷ غیرنظامی کشته و ۲٬۰۷۲ نفر زخمی شدهاند. اگرچه او باور داشت که اسرائیل «هیچ کاری به او ندارد»، اما واقعیت این بود که خطر بسیار نزدیکتر و جدیتر از آن بود که میدانست.

دلیل دسترسی نداشتن او به اطلاعات عینی چه بود؟ در طول قطع اینترنت، مردم ایران تقریباً مجبور بودند تنها به اخبار رسمی دولت تکیه کنند؛ اخباری که از میزان ویرانی بمبارانها کماهمیتنمایی میکرد، این تصور را جا میانداخت که حملات اسرائیل بیاثر است و ساکنان را ترغیب میکرد که از تخلیه خودداری کرده و زندگی عادی را ادامه دهند. با بازگشت اینترنت، ایرانیان با شکل دیگری از دستکاری اطلاعات روبهرو شدند؛ اینبار از سوی اسرائیل، که خود را در حال انجام «حملات دقیق» معرفی میکرد و جنگ را به نفع مردم ایران جلوه میداد. هیچکدام از این روایتها دقیق نبود و هر دو سوی ماجرا، مردم را در میان خشونت فزاینده، به حس امنیتی کاذب کشاند.

این شکاف هولناک میان واقعیت و روایتهای رسانهای و آنلاین، به یکی از ویژگیهای جنگهای مدرن بدل شده است. در ایران، گسترش تبلیغات و رسانههای مصنوعی با توجه به محدودیتهای سختگیرانه اینترنتی تشدید شده است. نتیجه این که شهروندان اغلب نمیتوانند اطلاعات دریافتی خود را با منابع دیگر مقایسه یا صحتسنجی کنند و ناچارند با دو چالش همزمان روبهرو شوند: نبود اطلاعات به دلیل قطع اینترنت، و آلودگی اطلاعات به دلیل تبلیغات پیش، حین و پس از این قطعیها.

آنچه این جنگ را از جنگهای پیشین متمایز میکند، افزایش چشمگیر استفاده از محتوای تولیدشده با هوش مصنوعی است. هرچند در درگیریهایی مانند ارمنستان، اوکراین و غزه نیز تصاویر تکراری، پخش زنده جعلی و صحنههای برگرفته از بازیهای ویدئویی دیده شده بود، اما محتوای تولیدشده با هوش مصنوعی در جنگ ایران و اسرائیل، جریان اطلاعات نادرست را به سطحی صنعتی رسانده است. حامیان اسرائیل ویدئوهای مصنوعی از تجمعات طرفدار اسرائیل در تهران منتشر کردند و ادعا کردند که این تصاویر نشاندهنده افزایش مخالفت با حکومت ایران است. در مقابل، حامیان ایران ویدئوهای تولیدشده با هوش مصنوعی از حملات موشکی به تلآویو را پخش کردند که حتی برخی از آنها دارای واترمارک «Google Veo» بودند، زیرا منتشرکنندگان فراموش کرده بودند این نشانههای آشکار جعلیبودن را حذف کنند. حتی تلویزیون دولتی ایران تصاویری ساختهشده با هوش مصنوعی از سرنگونی جنگندههای اف-۳۵ اسرائیل بر فراز ایران را پخش کرد. این حجم و سرعت انتشار محتوای جعلی بیسابقه بود. بهعنوان نمونه، فیلم انفجار اوین تنها یک ساعت پس از حادثه در شبکههای اجتماعی منتشر و بلافاصله توسط رسانههایی مانند اسکاینیوز و بیبیسی بازنشر شد. روایتهای نادرست به سرعت بر فضای اطلاعاتی جنگ مسلط شدند.

چالشهای شناسایی

مردم ایران سالهاست که آموختهاند اخبار دولتی را به دیده تردید بنگرند، اما تحول در رسانههای مصنوعی، لایه تازه و طاقتفرسایی از بیاعتمادی را به این فضا اضافه کرده است؛ به طوری که مردم بیش از پیش تردید میکنند آیا آنچه میبینند واقعی است یا خیر. افزون بر این، حجم و گستره تبلیغات مبتنی بر هوش مصنوعی، تحریک خشم، جلب مشارکت و فریب عمدی، تنها نوک کوه یخ است. ویدئوهای واقعینما با صدای هماهنگ تنها چند ماه است که وارد صحنه شدهاند، اما کیفیت و سهولت ساخت آنها با سرعت در حال افزایش است، بهویژه با دسترسی گسترده این ابزارها در پلتفرمهای عمومی.

این روندها بر تمام مراحل جنگ و حتی پیشگیری از آن اثر میگذارند. پژوهشهای پیشین WITNESS نشان میدهد که در شرایط جنگی، طرفهای درگیر برای تسلط بر روایت رقابت میکنند و همزمان تلاشهای گستردهای برای کسب درآمد از توجه جهانی صورت میگیرد. تصمیمات سرنوشتساز بر اساس اطلاعات موجود گرفته میشوند و فرایندهای صلح شکننده میتوانند با شایعات بهسرعت منتشرشده مختل شوند. پس از کودتای میانمار در ۲۰۲۱ و آغاز جنگ تمامعیار روسیه علیه اوکراین در ۲۰۲۲، نمونههایی از پخش زنده جعلی برای جلب توجه و کمک مالی دیده شد. در غزه، کمپینهای مشارکتی که در آن فعالان با استفاده از محتوای هوش مصنوعی توجه جهانی را جلب و هویت خود را ابراز میکنند، شکل گرفت. نمونه شاخص آن، شعار «All Eyes on Rafah» بود؛ تصویری مصنوعی از یک بیابان و اردوگاه چادری برای آوارگان فلسطینی که پس از حمله هوایی اسرائیل به رفح در مه ۲۰۲۴ بیش از ۴۷ میلیون بار به اشتراک گذاشته شد. این تصویر آشکارا مصنوعی و ابزاری برای کمپین بود، اما برخی تحلیلگران آن را به دلیل نشان ندادن «ابعاد واقعی فاجعه» – نمایش اردوگاهی خالی از انسان و بدون نشانههای جنگ – مورد انتقاد قرار دادند. پیچیدگی و واقعنمایی این روشها رو به افزایش است، در حالی که هزینه تولید آنها کاهش مییابد.

با این حال، جهان در برابر این چالشها بیدفاع نیست. فناوریهایی وجود دارد که میتوانند محتوای جعلی ساختهشده با هوش مصنوعی را شناسایی و وجود محتوای واقعی یا مصنوعی را علامتگذاری کنند. یک دسته از ابزارهای شناسایی، پس از انتشار محتوا و زمانی که اطلاعاتی از فرایند ساخت آن در دسترس نیست، به کار میروند و به دنبال نشانههای آماری یا ناهماهنگیهایی میگردند که میتواند بیانگر استفاده از هوش مصنوعی باشد. مثلاً، برخی ابزارها با مقایسه هماهنگی صدا و تصویر یا تطبیق محتوای مشکوک با نمونههای تأییدشده از فرد یا مکان، به کشف دستکاری میپردازند.

دسته دیگری از رویکردها – که «زیرساخت و استانداردهای منشأ و اصالت محتوا» نامیده میشوند – تلاش میکنند با افزودن برچسب یا واترمارک، جاسازی فراداده یا استفاده از اثرانگشت دیجیتال، منشأ و تاریخچه دادهها را ثبت کنند. ابزارهایی مانند SynthID گوگل یا استانداردهای فنی ائتلاف C2PA میتوانند در محصولات هوش مصنوعی و همچنین رسانههای واقعی و غیرمصنوعی، نشانهها و اطلاعات مفیدی ارائه دهند.

شناسایی پسینی هم ساده نیست. بسیاری از این ابزارها تنها برای یک قالب خاص از محتوای جعلی کارایی دارند و اغلب در برابر نسخههای بیکیفیت شبکههای اجتماعی ضعیف عمل میکنند. نمرههای اطمینان – مثلاً ۷۳ درصد احتمال جعلیبودن – نیز برای کاربرانی که از میزان دقت فناوری آگاه نیستند، مبهم است. افزون بر این، الگوریتمی که برای کشف دستکاری با هوش مصنوعی طراحی شده، ممکن است ویرایش دستی را تشخیص ندهد و محتوای موسوم به «شالوفیک» (ویدئوها و تصاویر با ویرایش یا بازمتنگذاری سبک) را که بسیار رایج هستند، شناسایی نکند.

برای نمونه، ویدئویی را در نظر بگیرید که رسانههای دولتی ایران در ۱۵ ژوئن منتشر کردند و مدعی بود حمله هوایی اسرائیل به خیابان برهان در محله تجریش تهران را نشان میدهد. این ویدئو صحنهای از ویرانی را به تصویر میکشید؛ ساختمانی ششطبقه ویرانشده، خودروهای آسیبدیده پراکنده و لولههای آب ترکیده – و به سرعت در تیتر خبرگزاریهای جهان قرار گرفت. اما برخی مخاطبان بلافاصله نسبت به دستکاری احتمالی این ویدئو پرسشهایی مطرح کردند. وقوع حمله به آن محله و همان خیابان، همچنین تعداد قربانیان کشته و زخمی، تأیید شد؛ اما زمانی که تحلیلگران مختلف اصالت ویدئو را بررسی کردند، نتایج یکسان نبود. برخی از ابزارهای پیشرفته شناسایی هوش مصنوعی که در «نیروی واکنش سریع دیپفیک» به کار گرفته میشوند، شواهدی از استفاده از هوش مصنوعی تولیدی در این ویدئو یافتند. کارشناسان این مرکز همچنین به چندین ناهماهنگی فیزیکی در تصاویر اشاره کردند که احتمال دستکاری با هوش مصنوعی را تقویت میکرد. اما گروه دیگری از محققان اطلاعات متنباز و تحلیلگران مستقل، از جمله BBC Verify و پروفسور «هانی فرید»، هیچ نشانه قطعی از جعلی بودن پیدا نکردند. این ویدئو که تصویربرداری از صفحه نمایش یک دوربین مداربسته بود، فاقد فراداده بود و ناهماهنگیهای فیزیکی داشت. با وجود این ابهامات، خبر بهسرعت بهعنوان «خبر فوری» منتشر شد. این پرونده حلنشده نشان میدهد که حتی پیشرفتهترین روشهای شناسایی نیز میتوانند نتایج متناقض ارائه دهند و روزنامهنگاران، مدافعان حقوق بشر و غیرنظامیان در مناطق جنگی ناچارند در میان مه غلیظ جنگ، بدون سیگنال روشن از واقعیت، مسیر خود را پیدا کنند.

با وجود نقصها، این ابزارهای شناسایی همچنان برای تشخیص استفاده فریبکارانه از هوش مصنوعی ضروریاند، اما اغلب در دسترس کسانی که بیش از همه به آن نیاز دارند – یعنی افراد در دل درگیری – قرار نمیگیرند. حتی زمانی که چنین ابزاری موجود است، بهدلیل طراحی نشدن برای جمعیتها، زبانها و قالبهای رسانهای متنوع جهانی یا به دلیل نداشتن خروجی قابلدرک برای روزنامهنگاران، افراد غیرمتخصص یا افکار عمومی تردیدکننده، کارایی چندانی ندارد. شناساییای که تنها در برخی موارد جواب میدهد، خطر ایجاد سردرگمی را بیشتر از حل مسئله به همراه دارد. در بسیاری از موارد، ادعاهای نادرست درباره دستکاری با هوش مصنوعی برای بیاعتبار کردن ویدئوهای واقعی به کار رفته و برعکس، این ادعا که محتوایی با هوش مصنوعی ساخته شده، برای نادیده گرفتن افشاگریهای حساس استفاده شده است.

طراحی ابزارها برای خط مقدم: سیاست و عمل

با ادامه بیثباتی و جنگ در جهان، شکاف میان توانایی جامعه برای تشخیص محتوای مصنوعی روزبهروز واقعیتر و ابزارهای شناسایی کارآمد در شرایط بحران، در حال گسترش است. ابزارهای ردیابی و شناسایی محتوای ساختهشده با هوش مصنوعی باید برای افرادی که در خط مقدم هستند، در دسترس و قابل استفاده باشد – WITNESS در چارچوب جدید خود به نام TRIED گامهایی برای شناسایی مؤثر جهانی پیشنهاد کرده است. در مورد ابزارهای منشأشناسی (provenance) نیز باید از ابتدا محیطهای سرکوبگر مانند ایران در نظر گرفته شود تا این ابزارها در چنین شرایطی کارآمد باشند و همزمان با افزودن قابلیتهایی که به دولتهای سرکوبگر امکان ردیابی و سرکوب مخالفان را میدهد، خطر برای کاربران را افزایش ندهند.

بهعنوان مثال، در طراحی ابزارهایی که فراداده جاسازیشده برای استفاده از هوش مصنوعی را نمایش میدهند، مشخص شده که پیوند زدن هویت افراد به تولید محتوا میتواند به نفع حکومتهای سرکوبگری تمام شود که پیشاپیش به دنبال خاموش کردن صداهای منتقد هستند. چنین قابلیتی هرچند ممکن است به شناسایی عاملان بدرفتار کمک کند، اما در عمل دریچهای پنهانی برای ردیابی مخالفان، طنزنویسان و شهروندان عادی بهدست میدهد که از ابزارهای هوش مصنوعی استفاده میکنند. بنابراین این ابزارها – اگر قرار است در مقیاس جهانی و در محیطهای پرخطر مانند ایران قابل استفاده باشند – نباید فرایند تولید رسانه را به هویت فردی پیوند بزنند. در عوض، باید صرفاً اطلاعاتی درباره ماهیت محتوا و چگونگی ترکیب ورودیهای انسانی و هوش مصنوعی در ساخت ویدئو ارائه دهند. از همان ابتدا، گنجاندن ملاحظات حقوق بشری و توجه به محیطهای سرکوبگر در طراحی این زیرساختها برای افزایش اعتماد در عصر هوش مصنوعی، امری حیاتی است.

هیچیک از این اقدامات عملی نخواهد بود مگر آنکه قوانین و تعهدات لازم تضمین کنند که شرکتهای فعال در تمام زنجیره هوش مصنوعی و رسانه – از مدلها و توسعهدهندگان گرفته تا ابزارها و پلتفرمها – مسئولانه وظیفه خود را در جاسازی اطلاعات منشأ، ایجاد امکان شناسایی مؤثر جهانی، علامتگذاری محتوای دستکاریشده فریبکارانه و دوچندان کردن اقدامات حفاظتی برای کاربران در مناطق پرخطر ایفا کنند.

در جریان آنچه «جنگ دوازدهروزه» خوانده شد، ایرانیانی که میان حملات هوایی اسرائیل و سرکوب جمهوری اسلامی گرفتار شده بودند، نمیدانستند باید از چه کسی یا چه چیزی خود را محافظت کنند. مخاطب ما در ستارخان که زمانی گفته بود اسرائیل هرگز آسیبی به او نخواهد رساند، بعدها تصاویری از دود بر فراز زندان اوین فرستاد، بیآنکه بداند باید چه چیزی را باور کند و از چه چیزی بترسد. و وقتی ویدئویی از بمباران خیابان برهان در تجریش منتشر شد، حتی پیشرفتهترین ابزارهای شناسایی و خبرهترین پژوهشگران نتوانستند بر سر واقعی یا مصنوعی بودن آن به توافق برسند. هرچند جنگ به آتشبسی شکننده رسیده، اما نبرد بر سر خودِ واقعیت همچنان ادامه دارد.